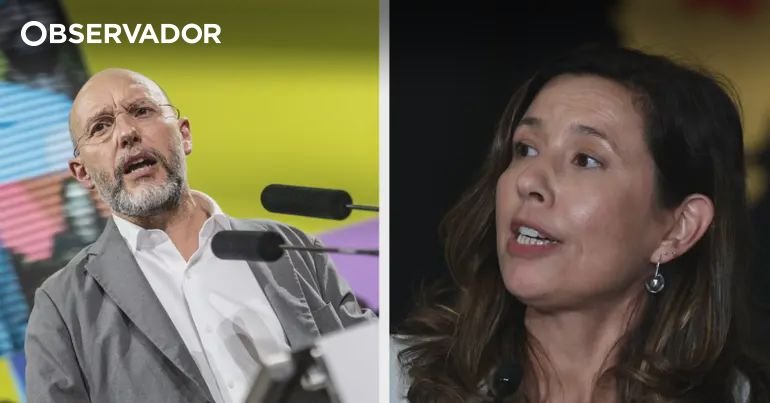

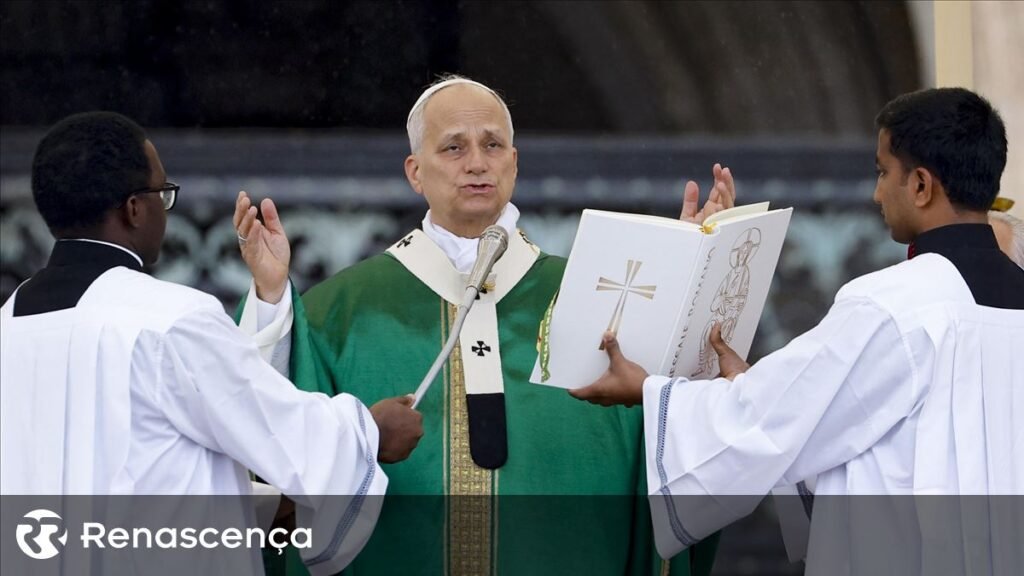

Investigadora: Verificação de factos demora a responder à desinformação

A pesquisadora do Instituto Superior Técnico (IST), Sofia Pinto, destacou que os atuais mecanismos de verificação de factos consomem muito tempo, o que contribui para a disseminação incontrolável de desinformação. Nesse contexto, a verificação automatizada de factos pode se configurar como uma solução viável.

“A verificação manual de factos jornalísticos é a abordagem habitual para lidar com notícias falsas, entretanto, essa tarefa laboriosa frequentemente não é adequada à amplitude do problema”, ressaltou, enfatizando que a verificação automatizada de factos (AFC, na sigla em inglês) pode ser uma “potencial solução”, conforme descrito no artigo “Verificação de factos automatizada e explicada para jornalistas”, escrito pela pesquisadora Sofia Pinto.

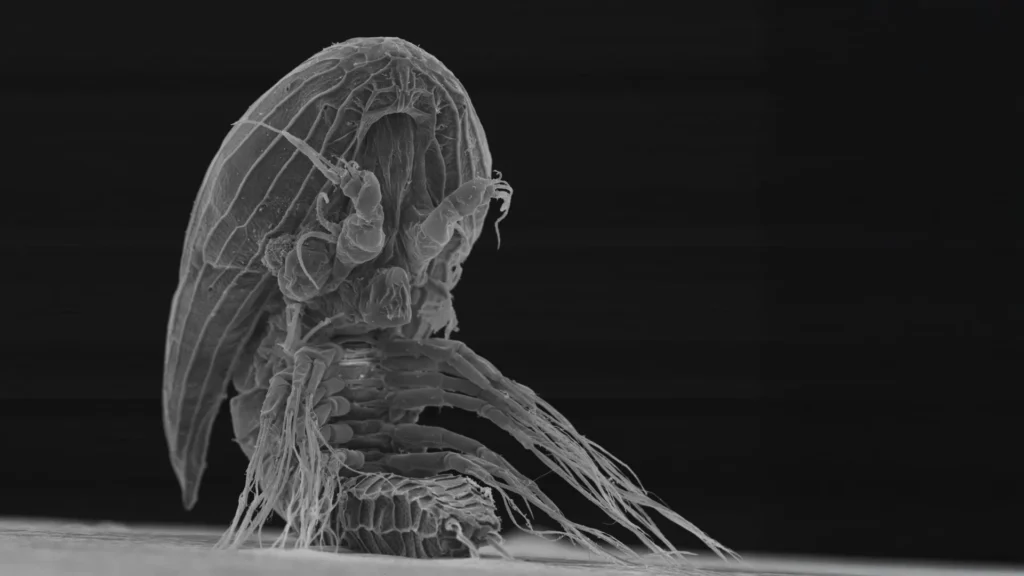

A verificação automatizada de factos se baseia em ferramentas de Inteligência Artificial (IA), utilizando modelos de linguagem em grande escala (LLMs) para gerar automaticamente conjuntos de dados de verificação de factos que possam suportar outras metodologias de confirmação.

“A verificação humana é crucial para mitigar os efeitos cada vez mais negativos das notícias falsas”, mas, de acordo com o documento, “a disseminação viral de algumas afirmações frequentemente torna essa atividade morosa e ineficaz”.

Em entrevista à Lusa, Sofia Pinto, integrante do IST na área de IA, explicou que um dos objetivos do projeto é acelerar a detecção de desinformação, uma vez que “demora muito” entre a viralização de uma publicação online e a divulgação de um desmentido por parte de um veículo de notícias.

“A tarefa jornalística de verificação e elaboração de explicações para notícias falsas ou manipuladas requer tempo e recursos, dificultando a possibilidade de interromper essa partilha viral logo no início, antes de sua disseminação incontrolável”, afirmou.

Para a pesquisadora, “o tempo que as desinformações levam para serem desmentidas resulta em notícias falsas ou manipuladas, repetidas sem restrições, que se tornam ‘verdades’ acreditadas por quem as lê. Além disso, os desmentidos produzidos pelos ‘fact-checkers’ nunca atingem a mesma viralidade, pois o assunto já teria perdido relevância, tornando-se ‘notícias de ontem’”.

Com o intuito de auxiliar nessa tarefa, a docente sugere uma “ferramenta que permita aos jornalistas melhorar a capacidade de reagir mais rapidamente à verificação de notícias”.

O modelo proposto “visa reduzir o tempo necessário para avaliar conteúdos com potencial de fake news”, agilizando a verificação de factos em conteúdos digitais para ajudar os jornalistas a enfrentar a problemática da desinformação.

O sistema de IA executa automaticamente todos os passos da verificação de factos que são realizados manualmente por jornalistas, necessitando apenas da identificação da afirmação a ser comprovada.

O usuário tem acesso a todas as etapas seguidas na obtenção de evidências, às fontes utilizadas na compilação das informações, e um veredicto fundamentado nessa informação, além de gerar um artigo explicativo das razões que levam à atribuição do veredicto em questão.

Sofia Pinto confessa que, apesar de ter “sido desenvolvido e testado em inglês, seria muito interessante desenvolver e verificar como se comporta uma variante em português”.

O trabalho envolveu um estudo com a participação de mais de cem jornalistas profissionais, visando validar o funcionamento do modelo e a qualidade das explicações geradas.

A iniciativa desenvolvida por alunos do IST integra o projeto CIMPLE, que se propõe a pesquisar e desenvolver explicações criativas e inovadoras de IA social e fundamentada no conhecimento, testando-as na detecção e rastreamento de informações manipuladas.

O CIMPLE fundamenta-se em modelos da criatividade humana, tanto na manipulação quanto na compreensão da informação, para criar explicações mais claras, adaptáveis e personalizáveis.